引言

DeepSeek 是一种功能强大的大语言模型,而 Ollama 是一个方便的工具,可用于在本地轻松部署和管理模型。本文将详细介绍如何在 Windows 系统上使用 Ollama 部署 DeepSeek 模型。

环境准备

安装Ollama (官网:https://ollama.com/download)

部署 DeepSeek 模型

1. 启动 Ollama 服务

打开命令提示符或 PowerShell,运行以下命令启动 Ollama 服务:

ollama serve这将启动 Ollama 服务,并监听默认端口(11434)。在服务启动过程中,你可能会看到一些日志信息,当看到服务成功启动的提示后,说明 Ollama 服务已经正常运行。

2. 部署 DeepSeek 模型

Distilled models 蒸馏模型

DeepSeek 团队已经证明,较大模型的推理模式可以提炼成更小的模型,与通过 RL 在小型模型上发现的推理模式相比,性能更好。

以下是使用 DeepSeek-R1 生成的推理数据,针对研究界广泛使用的几个密集模型进行微调而创建的模型。评估结果表明,提炼的较小密集模型在基准测试中表现非常出色。

部署命令

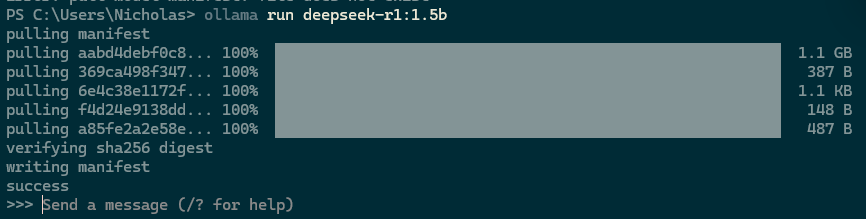

Ollama 提供了方便的命令来运行各种模型。要运行 DeepSeek 模型,在命令提示符或 PowerShell 中运行以下命令:

ollama pull deepseek-r1:1.5b这里演示的是最低需求性能开销的 deepseek-r1:1.5b 下面将列举运行其他 DeepSeek 模型命令,注意数据量越大的模型越吃系统性能。

DeepSeek-R1-Distill-Qwen-1.5B

ollama run deepseek-r1:1.5bDeepSeek-R1-Distill-Qwen-7B

ollama run deepseek-r1:7bDeepSeek-R1-Distill-Llama-8B

ollama run deepseek-r1:8bDeepSeek-R1-Distill-Qwen-14B

ollama run deepseek-r1:14bDeepSeek-R1-Distill-Qwen-32B

ollama run deepseek-r1:32bDeepSeek-R1-Distill-Llama-70B

ollama run deepseek-r1:70b如果需要其他模型可以去官网(https://ollama.com/search)检索

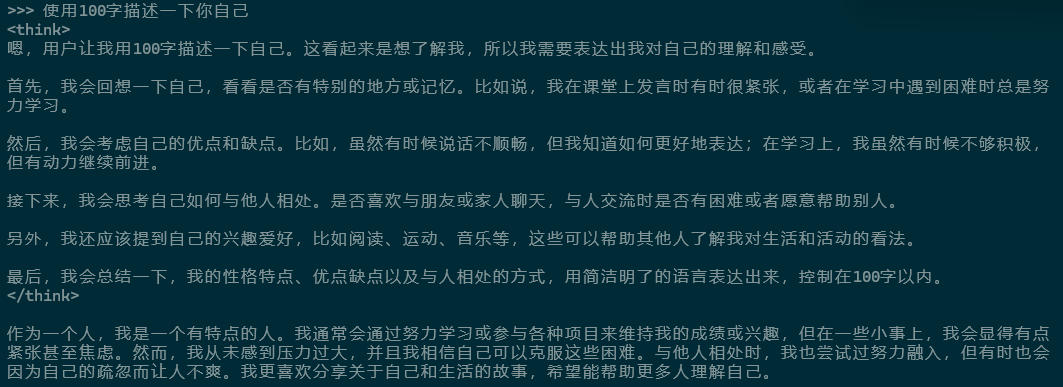

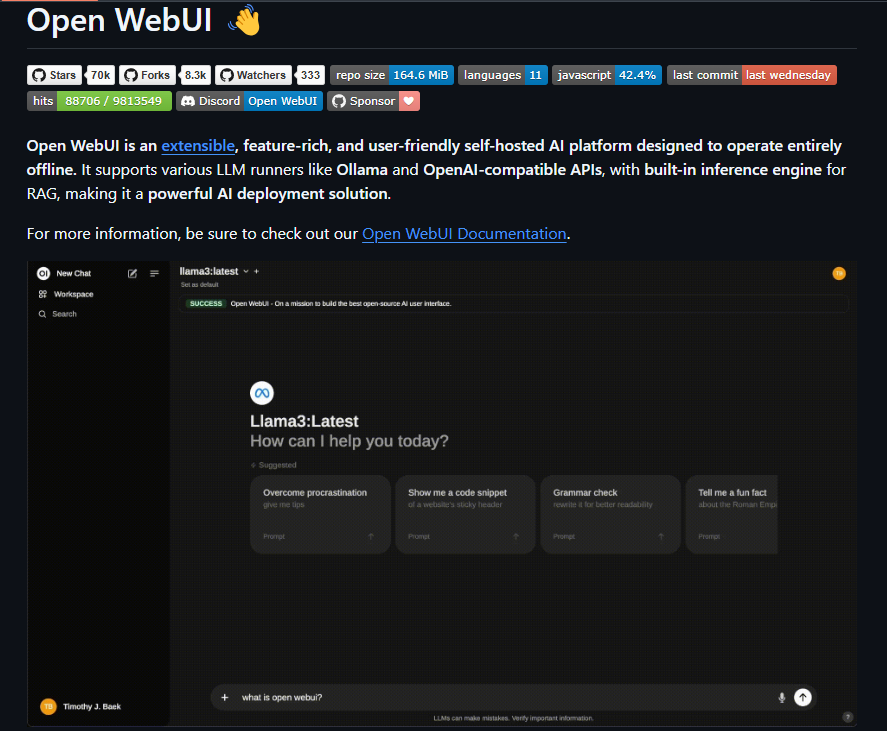

执行命令后Ollama会自动从服务区拉取模型这将会需要一点时间,稍等片刻后你将会看到如下界面

这个时候你可以直接在终端开始对话了。

当然有些朋友会说在命令行里面用起来也太不优雅了,所以我们需要一个聊天的UI界面

部署聊天UI界面

这里推荐两个方案,一个简单一个复杂,各位看官可以按需选择。

Page Assist - 本地 AI 模型的 Web UI

打开谷歌应用商店,安装一个名为 Page Assist 的谷歌浏览器插件

打开后可以看到自动识别了本地运行的 Ollama ,在右上角的小齿轮图标进入设置修改语言

在页面的左上角可以选择模型,然后就可以快乐的玩耍了~~~

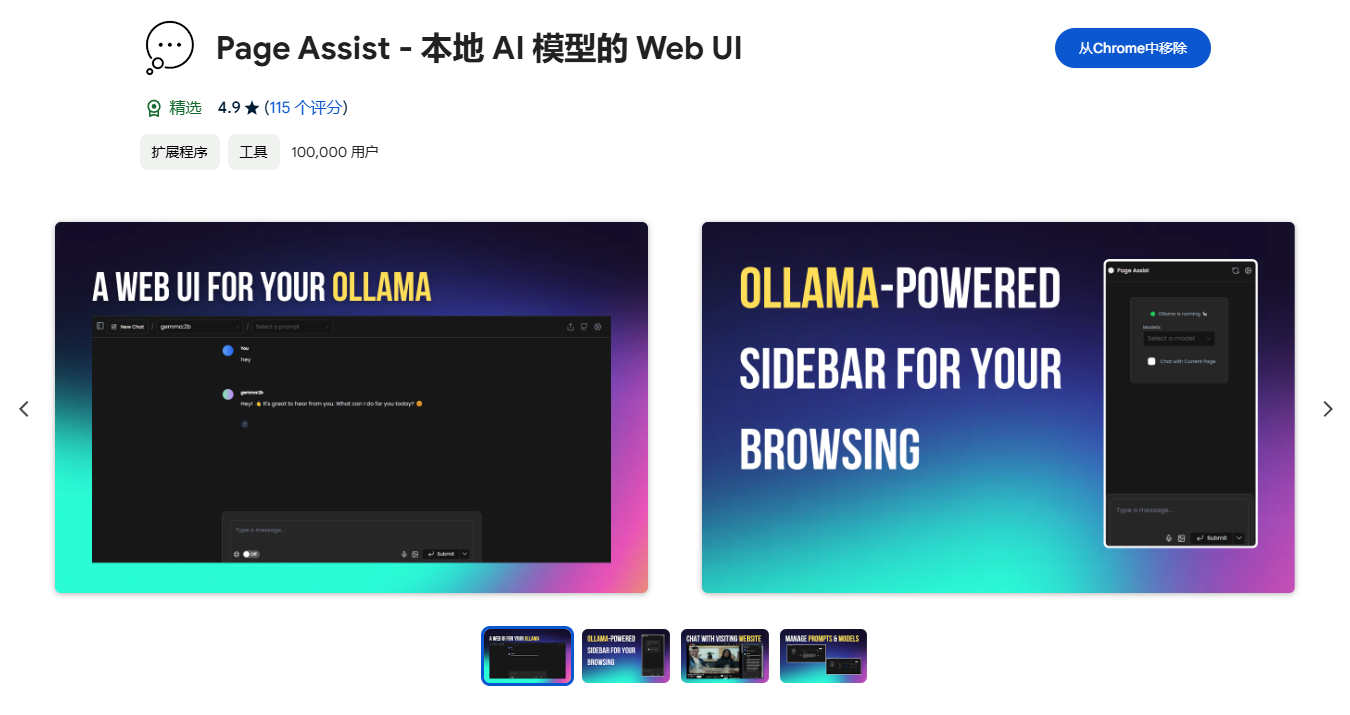

Open-Webui

Open - WebUI 是一个用于大语言模型(LLM)的用户界面项目,它旨在为用户提供一个简单、直观且功能丰富的方式来与各种大语言模型进行交互。项目官网:https://github.com/open-webui/open-webui

下面将会介绍如何使用 Docker Desktop 部署本地的 Open-Webui

安装Docker Desktop(官网:https://docs.docker.com/desktop/setup/install/windows-install/)

部署 Open-Webui

根据你的情况选择在命令提示符或 PowerShell 中运行命令

要运行支持 Nvidia GPU 的 open-webui,请使用以下命令:

docker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cuda如果你没有 Nvida GPU,请使用以下命令:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main等待命令执行完成你可以使用这个地址使用 Open-Webui :http://localhost:3000/

总结

当然所有的本地版模型肯定是不能和官方的满血版对比的,但是本地版有自己独到的优劣势。

优点:

不用联网:本地运行嘛

闪电反应:不需要等请求排队

私密性:记录只保留在本地

省钱:有些大模型是需要付费使用的

缺点:

只会简单技能:受限模型大小能力有限(谁家好人能有服务器集群捏~)

需要运行环境:占用系统资源(毕竟本地部署嘛)

不会进步:官网更新功能时它不会进步(因为模型文件都没变)

那么以上就是本文的全部内容了,希望可以帮助到你,也欢迎大家在下方评论区一起来讨论。

这里是Nicholas Hao,每天进步一点点,让我们下次见 ~~~ See ya ~~~